Les LLM, ou Large Language Models, sont au cœur de la révolution de l’intelligence artificielle. Derrière ce nom complexe se cachent des modèles capables de comprendre et de générer du langage humain. Vous les utilisez peut-être déjà sans le savoir : lorsqu’un chatbot vous répond ou qu’une intelligence artificielle générative résume un article.

Mais qu’est-ce qu’un LLM exactement ? Comment fonctionne cette technologie ? À quoi sert-elle dans la vie réelle ? Quels sont les modèles les plus connus aujourd’hui, et comment les utiliser ?

Dans ce guide complet, nous allons vous expliquer simplement ce qu’est un LLM, comment il est conçu, quelles sont ses limites, et pourquoi il est devenu un outil incontournable dans le monde de l’IA.

Qu’est-ce qu’un LLM ?

Un LLM, ou Large Language Model (modèle de langage de grande taille), est un programme d’intelligence artificielle capable de comprendre, générer ou compléter du texte en langage naturel. Cela signifie qu’il peut répondre à des questions, écrire des articles, résumer des documents, traduire des phrases ou même tenir une conversation.

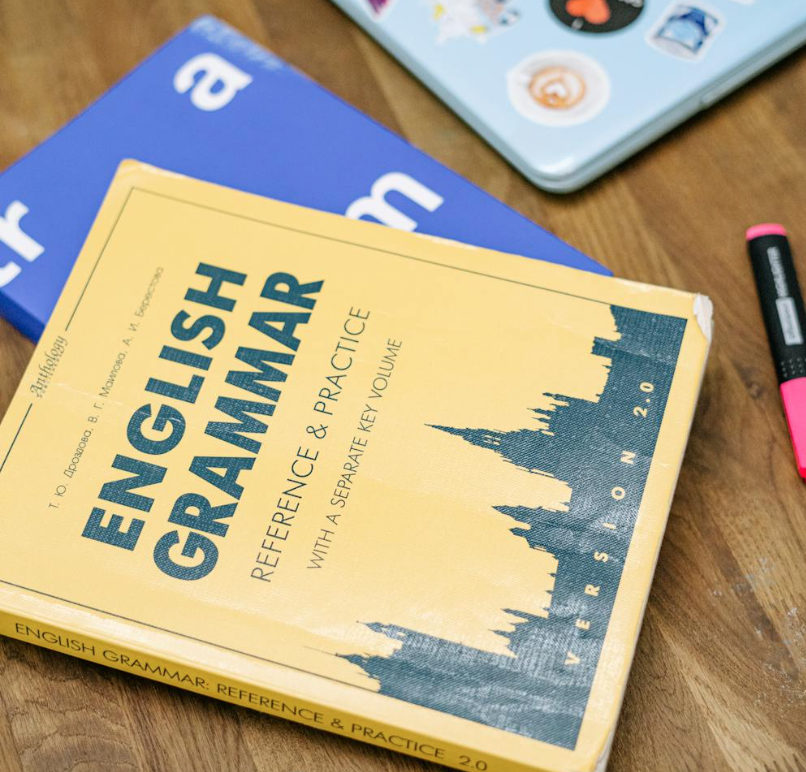

Concrètement, un LLM est entraîné sur d’énormes quantités de textes : livres, sites web, forums, articles scientifiques, lignes de code… Grâce à cet apprentissage, il apprend à prédire le mot suivant dans une phrase, ce qui lui permet de produire du texte cohérent et souvent pertinent.

Un LLM ne comprend pas le sens des mots comme un humain. Il fonctionne sur la base de probabilités. Il repère des schémas dans les textes qu’il a lus et s’en sert pour générer des réponses adaptées à votre demande, qu’on appelle un prompt. Vous pouvez en apprendre plus sur les prompts dans cet article.

Ces modèles sont dits “grands” car ils contiennent des milliards de paramètres. Plus un LLM a de paramètres, plus il est capable de traiter des situations variées et de produire des réponses complexes. Par exemple, GPT-3 comptait 175 milliards de paramètres, GPT-4 encore plus. Des modèles comme Claude, LLaMA, Gemini ou Mistral fonctionnent sur le même principe.

Comment fonctionne un LLM ?

Le fonctionnement d’un LLM peut sembler complexe, mais il repose sur quelques grands principes qu’on peut expliquer simplement. Un LLM est un modèle d’intelligence artificielle qui a été entraîné à prévoir le mot suivant dans une phrase. À force de répétition, il devient capable de produire des phrases entières, puis des paragraphes cohérents, sur presque n’importe quel sujet.

L’apprentissage à partir de grandes quantités de texte

Un LLM apprend en lisant. On le nourrit avec d’immenses quantités de textes : des livres, des articles de presse, des sites web, des messages sur des forums, du code informatique, etc. Tout ce contenu est transformé en une forme numérique que le modèle peut analyser, mot par mot, ou plus précisément token par token (un token est un morceau de mot ou de phrase).

Plus le modèle lit de textes variés, plus il est capable de repérer des schémas, des structures de phrases, des tournures spécifiques, et d’apprendre à les reproduire.

Les réseaux de neurones et les transformers

Au cœur d’un LLM, on trouve un réseau de neurones artificiels. Ce système s’inspire vaguement du cerveau humain, mais fonctionne de manière mathématique. Ce réseau passe les informations à travers plusieurs couches de calcul, en ajustant des poids numériques qui influencent les réponses du modèle.

La grande innovation récente, c’est l’architecture dite “transformer”. Elle permet au modèle de se concentrer sur les parties les plus importantes d’un texte pour mieux comprendre le contexte. Par exemple, dans la phrase “Paul a vu Marie, elle souriait”, le modèle doit comprendre que “elle” fait référence à Marie, pas à Paul. Le transformer rend ce genre de raisonnement possible.

L’ajustement final : fine-tuning et RLHF

Une fois le modèle entraîné, il est souvent réajusté pour mieux répondre aux attentes humaines. On appelle cela le fine-tuning. C’est une deuxième phase d’apprentissage, plus ciblée.

Certains LLM ont aussi un entraînement avec retour humain : c’est le RLHF (Reinforcement Learning with Human Feedback). Des humains évaluent les réponses du modèle, et l’IA apprend à privilégier les réponses jugées utiles, claires ou sûres.

À quoi sert un LLM ?

Les LLM ne sont pas seulement impressionnants en théorie : ils ont des usages très concrets dans la vie quotidienne comme dans les métiers spécialisés. Grâce à leur capacité à comprendre et à générer du langage, ils peuvent remplir de nombreuses fonctions utiles.

Quelques exemples concrets d’utilisation d’un LLM :

| Usage | Exemples réels |

| Répondre à des questions | ChatGPT, Claude, Bing Copilot |

| Écrire ou reformuler des textes | Rédaction d’e-mails, de résumés, de descriptions produits |

| Traduire automatiquement | Traduction multilingue avec Deepl, Google Translate amélioré par LLM |

| Aider à apprendre ou à réviser | Explications de notions, quiz interactifs, synthèses de cours |

| Aider à coder | GitHub Copilot, Codex, génération de scripts Python ou HTML |

| Analyser ou trier des documents | Résumé de contrats, extraction d’informations dans des PDF |

| Jouer un rôle conversationnel | Coach virtuel, simulation de dialogue, scénarios interactifs (éducation, santé…) |

| Créer du contenu original | Histoires, poèmes, slogans, posts pour les réseaux sociaux |

Ces usages évoluent très vite. Aujourd’hui, les LLM sont déjà utilisés dans l’éducation, le marketing, la finance, la médecine, la programmation, le support client, la création artistique…

Exemples de LLM connus (mise à jour 2025)

Depuis l’arrivée de ChatGPT fin 2022, les modèles de langage se sont multipliés. Certains sont accessibles au grand public, d’autres sont open source, et plusieurs sont développés en Europe, en Asie ou aux États-Unis. Voici une sélection des LLM les plus connus et les plus utilisés aujourd’hui :

| Nom du modèle | Créateur | Année | Type | Accès | Langues |

| GPT-5 | OpenAI | 2024 | IA générative | Gratuit et payant | Multilingue |

| Claude 3 | Anthropic | 2024 | Conversationnel | Gratuit et payant | Multilingue |

| Gemini 1.5 | Google DeepMind | 2024 | Multimodal | Gratuit (via Google) | Multilingue |

| Mistral 7B | Mistral AI | 2023 | Open source | Téléchargeable / via Ollama | Anglais (principalement) |

| Mixtral 8x7B | Mistral AI | 2023 | MoE (experts mixtes) | Open source | Anglais / partiel Francais |

| LLaMA 3 | Meta | 2024 | Open source | Téléchargeable | Anglais / partiel Francais |

| Command R+ | Cohere | 2024 | Raisonnement | API / intégrations | Multilingue |

| Yi 1.5 | 01.AI (Chine) | 2024 | Multilingue | Open source | Fort en anglais et chinois |

Analyse des LLM existants

Le paysage des LLM en 2025 est dominé par quelques acteurs majeurs, chacun avec une approche bien distincte. OpenAI reste en tête avec GPT-4, intégré à ChatGPT, Bing Copilot et d’autres services professionnels. Son modèle est fermé, payant, mais reste une référence en termes de performance et de polyvalence. De son côté, Anthropic mise sur la sécurité et la structure, avec Claude, un assistant souvent salué pour la clarté et la nuance de ses réponses. Google, avec Gemini, a choisi l’intégration à grande échelle : son LLM alimente Gmail, Docs, Search et Android, dans une logique de fusion totale avec ses outils.

En parallèle, Mistral AI, jeune entreprise française, s’est imposée avec des modèles open source compacts et puissants, très prisés par les développeurs et les chercheurs. Meta continue à publier la série LLaMA, également en open source, utilisée dans de nombreux projets de recherche ou d’expérimentation. Ce qui frappe, c’est la diversité des stratégies : certains misent sur l’ouverture, d’autres sur l’intégration commerciale ou la maîtrise fine des réponses.

L’avenir des LLM : où va cette technologie ?

Aujourd’hui, les LLM évoluent à grande vitesse. Les modèles s’améliorent, deviennent plus compacts, plus rapides, parfois open source. OpenAI propose désormais GPT-4 avec mémoire longue et fonctions vocales. Google intègre Gemini dans tous ses outils. Anthropic, Mistral, Meta, xAI et d’autres avancent chacun à leur rythme, poussant l’innovation toujours plus loin.

Certains modèles comprennent des images, d’autres traduisent en temps réel, génèrent du code ou s’adaptent au ton d’un utilisateur. Des agents autonomes commencent à apparaître, capables de prendre des décisions simples à la suite d’un objectif donné.

Mais malgré ces progrès, beaucoup de questions restent ouvertes. Que deviendront ces outils ? Seront-ils des compagnons invisibles du quotidien, ou des systèmes puissants que seuls certains contrôleront ? Seront-ils localisés, éthiques, transparents ? Ou centralisés, opaques, inégalement répartis ?

Impossible de répondre aujourd’hui. Ce que l’on sait, en revanche, c’est que les LLM continueront d’évoluer. Et que le vrai défi sera moins technologique qu’humain : comment les comprendre, les encadrer, et en faire des outils qui servent plutôt qu’ils ne dominent.